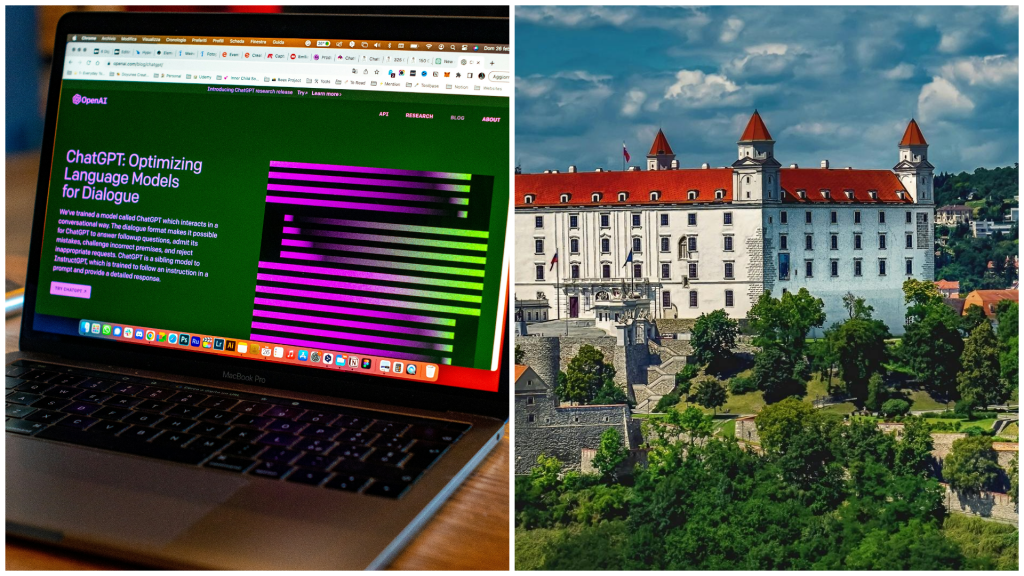

Spoločnosť tak umožnila získať terapeutickú pomoc viac ako 4-tisíc ľuďom, a to pomocou chatbota GPT-3. Problémom však bolo, že o ničom netušili, ani len o tom, že si nepíšu s človekom, ale umelou inteligenciou, informuje web Ars Technica.

Koko je nezisková platforma pre duševné zdravie, ktorá spája dospievajúcich a dospelých, ktorí potrebujú pomoc v oblasti duševného zdravia, s dobrovoľníkmi prostredníctvom aplikácií na odosielanie správ, ako sú Telegram a Discord.

Na Discorde sa používatelia prihlásia na server Koko Cares a posielajú priame správy robotovi Koko, ktorý kladie niekoľko otázok s možnosťou výberu z viacerých odpovedí (napr. „Aká je tvoja najtemnejšia myšlienka?“). Potom zdieľa obavy osoby – napísané ako niekoľko viet textu – anonymne s niekým iným na serveri, ktorý môže anonymne odpovedať vlastnou krátkou správou.

Počas experimentu umelej inteligencie, ktorý sa podľa spoluzakladateľa týkal asi 30-tisíc správ, mali dobrovoľníci poskytujúci pomoc ostatným možnosť použiť odpoveď automaticky vygenerovanú veľkým jazykovým modelom OpenAI GPT-3 namiesto toho, aby si s nimi sami písali (GPT-3 je technológia za nedávno populárnym chatbotom ChatGPT).

Myšlienka použitia AI ako náhradu za terapeuta nie je pritom nová, ale rozdiel medzi experimentom Koko a typickými prístupmi k terapii za použitia umelej inteligencie je v tom, že ľudia zvyčajne vedia, že sa nerozprávajú so skutočným človekom. Napríklad, jeden z prvých chatbotov, ELIZA, simuloval psychoterapeutické sedenie.

Kontroverzný experiment

Na konci leta minulého roka niektorí používatelia vo veku od 18 do 25 rokov na sociálnych médiách zverejnili jedno z viac ako tisícky kľúčových slov (napr. „depresia“, „cítiť sa pod psa“), ktoré naznačovali, že im hrozí možné ublíženie. Bez varovania boli presmerovaní na chatbota.

Keď algoritmus Koko detekoval u ľudí jazyk „súvisiaci s možnou krízou“, presmeroval ich na vlastnú platformu Koko, kde im boli predložené zásady ochrany osobných údajov a podmienky služby, v ktorých sa uvádza, že ich údaje môžu byť použité na výskumné účely.

Chatbot sa potom spýtal: „S čím sa vyrovnávaš?“ Ak ich odpoveď naznačovala, že sú v možnom ohrození, poslal ich do takzvaného „krízového toku“ a opýtal sa, či mávajú aj samovražedné myšlienky, sebapoškodzujú sa, zápasia s poruchou príjmu potravy, zneužívaním alebo niečím iným, po čom boli náhodne zaradení do jednej z dvoch skupín.

Jednej skupine, kontrolnej, bolo poskytnuté číslo na krízovú horúcu linku. Druhá dostala „jednominútovú vylepšenú krízovú intervenciu“. Používateľom bol zaslaný formulár s otázkami, v ktorých ich chatbot žiadal, aby uviedli spúšťače ich psychických ťažkostí.

Následne sa ich spýtal, či budú schopní každý deň odpovedať na otázky a tak zlepšovať kvalitu služieb. Ak používateľ klikol na „Áno“, na ďalšej snímke bolo uvedené „Ďakujem! Tu je mačka!“. Používatelia následne dostali gif s mačkou.

Kritici tvrdia, že Koko porušila etické normy určené na ochranu zraniteľných ľudí pred škodlivými alebo zneužívajúcimi výskumnými postupmi. Rob Morris, spoluzakladateľ Koko, sa ku kritike vyjadril na svojom Twitteri.

„Kritiku, obavy a otázky týkajúce sa tejto práce prijímam s empatiou a otvorenosťou. Zdieľame záujem o to, aby sa akékoľvek použitie AI riešilo citlivo, s hlbokým záujmom o súkromie, transparentnosť a zmiernenie rizika. Naši odborníci sa stretli na porade, aby prediskutovali usmernenia pre budúcu prácu, najmä pokiaľ ide o schválenie IRB (revízna rada, pozn. red.).“

Čo sa legislatívy týka, v USA je to o niečo „divokejšie“ než v Európe. V Spojených štátoch je nezákonné vykonávať výskum na ľuďoch bez právne účinného informovaného súhlasu, pokiaľ IRB nezistí, že súhlas možno odmietnuť. Tento konkrétny zákon však platí len na federálne výskumné projekty.